Érdekes kísérletről adtak hírt nemrég szakmai portálok: ezek szerint az emberek már jobban megbízhatnak digitálisan „előállított” arcokban, mint a valódiakban, ráadásul nehezükre esik megkülönböztetni az igazit és a hamisat. De hová vezethet mindez?

Bár néha úgy tűnhet, hogy a mesterséges intelligencia kérdéskörében kissé szkeptikusak vagyunk itt a Pont.Most szerkesztőségében, azért (némi fenntartással ugyan, de) szeretjük az AI-t, és rendre foglalkozunk is a témával. Többek közt azért is, mivel már jelen pillanatban is olyan szinten hálózza be a mindennapjainkat ez a technológia – a közeljövőről nem is beszélve -, hogy nem is mehettünk el amellett a hír mellett szó nélkül, ami azt taglalja, hogy egy friss kutatás szerint a gépi tanulás segítségével, mesterségesen generált „emberi” arcokat megbízhatóbbnak gondoljuk, mint a valós személyekről készült fotókat. Ez elsőre még inkább csak afféle tech-bulvárnak tűnő szalagcímnek tűnik, azonban pont az utóbbi években látható, hallható és olvasható események tükrében sok mindent elárul az emberiségről és újabb óvatosságra int minket, amikor az életünk egyre több elemét az AI és a gépi tanulási algoritmusok “kezébe” tesszük.

A deepfake, a személyiség-lopás, az adatszivárgások nyomán terjedő hamis információk és áltudományos hírek mellett most már nyugodtan kijelenthetjük, hogy a saját szemünknek sem hihetünk. Ráadásul egyre nehezebb leleplezni a digitális megtévesztés eszközeit és ugyancsak nem könnyű utolérni azokat, akik felelősek a megtévesztésért. Mostantól ugyanis tényleg nem tudhatjuk, hogy ki – vagy még pontosabban MI (tetszenek érteni, Mesterséges Intelligencia) – bújik meg egy bizalomgerjesztő profilon található fotósorozat mögött.

A robotfej szimpatikus, a robotfej átver

Persze a ló másik oldalára sem kell átesni, és attól rettegni, hogy innentől minden Facebook vagy Twitter profil kamu, ami a szemünk elé kerül, és hogy az AI minden esetben átvág majd minket, de azért elég elgondolkodtató az a felmérés, amelyet Sophie Nightingale, a Lancaster Egyetem és Hany Farid a Berkeley Egyetem kutatói végeztek el. Két, egyenként több száz főből álló csoportban vizsgálták ugyanis az emberi arcokat ábrázoló fotókra érkezett reakciókat a projektben résztvevőkön. A feladat nem volt túl bonyolult: fel kellett ismerni a mesterséges intelligencia – egészen pontosan a generatív adverzális hálózat (angolul generative adversarial network, vagyis GAN) – által alkotott “személyeket” a valódi arcok között, valamint el kellett dönteniük, hogy kiket ítélnek a képek alapján megbízhatóbbnak. A képeken vegyesen, különböző korú, nemű, bőrszínű embereket láthattak a résztvevők. Két csoporton tesztelték a sorozatot: az első tagjai majdnem minden második arc esetében tévedtek, míg a másik csoport tagjai egy hangyányit jobban teljesítettek, ott 59%-ban tudták megállapítani kik a valós személyek a fotókon. Ám ennél egy kicsit érdekesebb, hogy – ugyan mindössze 8%-os különbséggel – de a szimpatikus, megbízható arcok között több volt a GAN algoritmus által generált, mint a valódi.

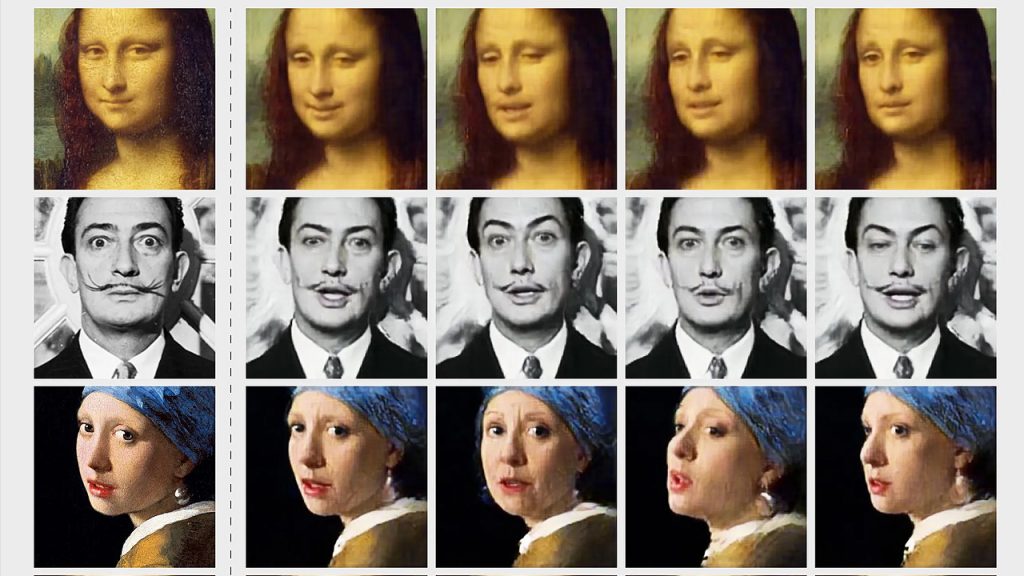

Pont egy évvel ezelőtt számoltuk be a Metahuman projektről, melyben az NVIDIA, az Intel és a világ egyik legsikeresebb játékfejlesztő motorja, az Unreal Engine segítségével “élő” és megdöbbentően realisztikus mozgó és beszélő „műembereket” állítottak elő, amiket mi felhasználók utólag akár magunk is módosíthattunk. A fenti kutatás és a deepfake technológia rohamos fejlődésének tükrében egyre jobban oda kell figyelnünk, hogy mi a valós információ, és mi a gyártott, “alternatív valóság”, amit mi sem bizonyít jobban, mint az ukrán elnök nemrégiben kikerült videója, amiben fegyverletételre szólította fel az ukrán katonákat – az egészben viszont az a félelmetes, hogy természetesen Zelenszkij semmi ilyet nem mondott, a feltételezhetően orosz kötődésű hackerek azonban hihetetlenül valósághűre és hihetőre faragták a beszédet, és egy technológiához kevésbé értő közönségréteg akár tényleg el is hihette (a gyorsan érkező cáfolatig), hogy valóban az elnök szólítja fel őket is a megadásra.

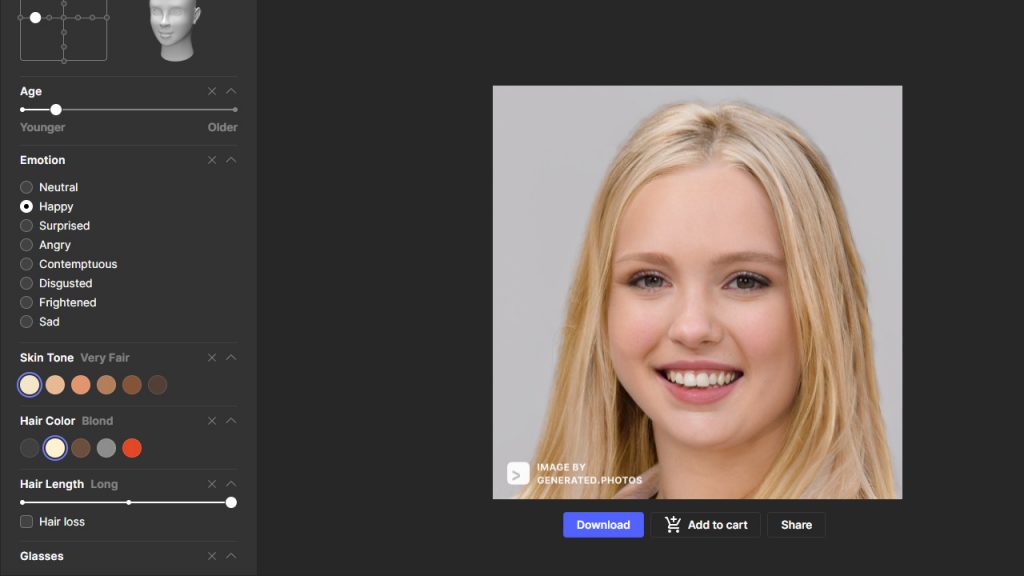

Egyébként mi magunk is tesztelhetjük, felismerjük-e a csalafintaságot: a This Person Doesn’t Exist nevű weboldalon olyan arcképeket találunk, amelyeket a mesterséges intelligencia valós portrék apró darabkáinak összekeverésével rakott össze: ha egy új arcot szeretnénk, csak frissítsük az oldalt, vagy a jobb alsó sarokban kérjünk váltást az “Another” linkre kattintva. Itt egyébként mesterséges macskákat, festményeket, de még lovakat is mutat nekünk az oldal, ha ilyesmiken kísérleteznénk. Ha pedig szeretnénk kipróbálni, hogyan lehet csupán néhány általunk megadott jellemzőből kisakkozni egy nem létező arcot, itt egy “arcgenerátor” a sok közül, amelyek egyre többfelé érhetőek el a weben, vagy valamilyen app formájában.

Ki mondja meg, valódi-e egy arc?

Amennyire ellenünk van az egyik oldalon a technika, úgy zajlanak a fejlesztések az ilyen és hasonló képek, videók minél egyszerűbb leleplezésére irányulva, melynek egyik legfrisebb példája a V7 Labs által fejlesztett kis szoftver, amit a Chrome böngésző bővítményeként használhatunk. A megoldás segítségével a “tüzet, tűzzel” analógiához hasonlóan gépi tanulással küzdünk a gépi tanulás által előállított termékek ellen, ugyanis a bővítmény segít felismerni a különféle generált, vagyis a nem valós emberi arcokat, amit közel 100%-os pontossággal tesz meg: a sikerrátája egész pontosan 99,28%, ami tényleg nagyon meggyőző.

Azonban itt sem fenékig tejfel minden, hiszen míg az egyszerűbb, mesterséges intelligencia által önállóan generált arcok esetén – amit akár mi magunk is megtehetünk szimplán egy weboldalon keresztül – tényleg jól működik, addig a valós személyeket ábrázoló komolyabb deepfake anyagokkal (mint például a fent említett, ukrajnai fegyverletételről szóló videó) már a V7 szoftvere is nehezen boldogul. Ennek az az oka, hogy az egyszerűbb – akár ingyenes, webes – megoldások általánosabb, sokakra jellemző arcvonásokkal és egyéb külső tulajdonságokkal operálnak, és ezen “alkatrészekből” random válogatva állítanak össze egy új arcot, míg a fejlettebb algoritmussal és jobb “alapanyagból” dolgozó, valós személyekre épülő manipulációk esetén nem lesz elegendő támpontja a szoftvernek. Ennek ellenére a V7 alkalmazása egy hatékony és sajnos már jelenleg is hasznos eszköz lehet az átlagos netező “fegyvertárában” is – ha valaki szeretne biztosra menni abban, hogy egy képen vagy egy videóban valóban azt látja, akit elsőre láttatni akarnak, pattintsa fel a kis kiegészítőt a Chrome alá.