Mióta számítógépek léteznek, fel-felbukkan világszerte az aggodalom, mikor veszik át az uralmat a világ fölött a gépek. A mesterséges intelligencia térnyerése még jobban felszította a kedélyeket: de vajon valósak a félelmek?

A Terminátor-filmekben Skynet néven képzeltek el egy olyan mesterséges intelligenciát, amely egy idő után eléri azt a szintet, amikor értelmi képességeit tekintve lehagyja az emberiséget, viszont mivel morális és érzelmi döntések nem befolyásolják, neki is áll eltaposni egykori megalkotóit. A filmklasszikus első részének bemutatása óta gyakran illetik egyesek Skynet néven az összes olyan újdonságot, amellyel a számítástechnika előrukkol, főként az olyan fejlesztéseket, amelyek valamilyen szintű önálló “gondolkodásra”, öntanuló képességekre épülnek. A hihetetlenül népszerű ChatGPT, az önvezető autózás vagy az egyre-másra érkező appok formájában terjedő generatív kép- és videószerkesztők révén már olyanokhoz is eljutott az MI legfrissebb generációjának híre, akik kevésbé követik az informatika világát, ezért egyre szélsőségesebb vélemények látnak napvilágot a témában.

Érdekes módon leginkább a mérsékelt, minden szempontot mérlegelő középút hiányzik, annál többször hallani olyan sarkos megjegyzéseket, miszerint “észre se vesszük, és egyszer csak a gépek irányítják az életünket”, vagy épp “nincs mitől félni, amíg a ChatGPT azt hiszi Einsteinről, hogy egy focista”. Tehát akkor hol is az igazság, kell-e tartani az MI-től? Nos, ha az uralmat nem is veszi át az emberiség felett, de ugyanúgy, mint minden eszközt a kalapácstól az atomig, szabályozni kell.

A gépagyak máshogy gondolkoznak

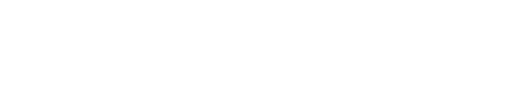

Azt már nagyon sok helyen megfogalmazták a mesterséges intelligenciával foglalkozó szakértők, hogy az MI ugyan valóban képes egyfajta gondolkodásra, de az teljesen más módszert használ, mint az emberi agy működése. Még az öntanuló rendszerek sem képesek arra, hogy olyan funkciókat építsenek be saját működésükbe, amely eltéríti őket eredeti céljuktól, és saját magukat “szuperhumánra okosítva” egyszer csak öntudatra ébredjenek. Az öntanulást inkább úgy kell elképzelni, mint egy olyan folyamatot, amely az eredeti céljuk elérését gyorsítja, finomítja: egy gazdasági folyamatokat elemző MI-segéd például egyre pontosabb meglátásokat tud közölni a folyamatosan bővülő adatforrások és a saját “tapasztalatok” alapján, míg egy chatbot sem kezd el nekünk parancsokat osztogatni az egyre komolyabb adatmennyiségének köszönhetően, legfeljebb az idő előrehaladtával kevesebb pontatlanságot épít majd be a mondandójába, amikor kérdezünk tőle valamit.

Az OECD definíciója szerint egy MI-rendszer szoftveralapú vagy hardvereszközökbe ágyazott rendszer, amely intelligenciát szimuláló viselkedést mutat többek között adatok gyűjtése és feldolgozása, környezetének elemzése és értelmezése, valamint azáltal, hogy konkrét célok elérése érdekében – bizonyos mértékben autonóm módon – cselekszik. Dr. Tilesch György, a téma nemzetközi szaktekintélye szerint itt az intelligencia szimulálása nagyon fontos megfogalmazás. A vele készült interjúnkban így fogalmazott: “A saját véleményem az, hogy a mostani, főleg generatív alapú megoldások sok tekintetben jól működnek, de még mindig sok más téren hibáznak. Már jelenleg is hasznosan alkalmazhatóak például üzleti területeken, viszont azt mereven tagadom, hogy ez jelentené az utat a klasszikus értelemben vett, emberi gondolkodást emuláló általános mesterséges intelligenciához: annak tekintetében inkább egy zsákutca, még ha hasznos és fontos is egyben, és persze maximálisan ki is használja tudásban és pénzügyileg is a világ a jelenlegi szinten.”

Ha nagyon leegyszerűsítjük, a mesterséges intelligencia jelenleg arra képes a különféle megvalósítási formáiban, hogy előzetes betanítás és a működés közbeni öntanulás révén átvesz egy sor emberi tevékenységet, legyen szó akár arról, hogy egy fotóról eltünteti a háttérben látható, zavaró elemeket, vagy épp összegyűjti a rendelkezésére álló információhalmazból a kéréseinkre adható válaszokat. Ennél persze sokfelé már komolyabb felhasználási területei is vannak, hozhat akár konkrét döntéseket is, de végső soron ezek is csak olyan döntések, amelyeket a megfelelő infóhalmaz ismeretében emberek is meghoznának.

Egy gyártási folyamatban alkalmazott MI például figyeli, milyen alkatrészek hogyan fogynak, mennyi a beszerzési idejük, hogy alakul az áruk, majd ez alapján akár automatikusan is leadhat ezekre rendeléseket. Azt jelenti ez, hogy öntudatra ébredt? Nem, csupán azt, hogy így állították be, tehát olyan döntést már biztosan nem hoz majd, hogy hagyjuk az eddig gyártott árukat a fenébe, termeljünk helyette inkább űrhajót vagy atombombát.

A másodlagos hatástól már ér tartani

Akkor mi is az a terület, ahol mesterséges intelligenciától félni lehet? A válasz nagyon leegyszerűsítve az, hogy nem magától az MI-től kell tartani, hanem azoktól az emberektől, akik az algoritmusok felhasználásával jóval többre képesek a korábbinál, és ezt nem feltétlenül csak erkölcsös és jó dolgokra használják, és itt megint csak a kalapácsos hasonlatot hozzuk, ami jó kezekben szerszám, rosszakban pedig fegyver. Apró bosszúságoktól és megtévesztésektől egész komoly szintekig ki lehet használni az algoritmusok erejét, nézzünk néhány példát.

Olyan esetekről ne is beszéljünk, amikor igazából nem is MI-ről van szó: az alkalmazásboltokban mostanában megjelent egy csomó olyan app, amire rábiggyesztenek valami olyan meghatározást, mintha tényleg valamilyen modern algoritmus dolgozna bennük, de igazából csak arra valók, hogy minél több adatot gyűjtsenek rólunk. Az viszont már teljesen más kategória, hogy milyen adatokat használnak és tárolnak a valóban MI-re alapozó megoldások. Érdemes jól végignézni a felhasználási feltételek között, hová kerülhetnek például a ChatGPT-nek és társainak kikotyogott információk, mennyire használhatja fel ezeket például az algoritmusok fejlesztője. Könnyű ugyanis olyan beszélgetésbe elegyedni egy chatbottal, amikor mondjuk a munkánkat szeretnénk megkönnyíteni vele, és azt mondjuk: “Írj helyettem egy összefoglalót a cég legutóbbi pénzügyi eredményeiről”, majd amikor több adatot kér, szépen elmesélni neki a bizalmas üzleti információkat. Nem is csoda, hogy egyre több vállalat megszabja, hogy a belső folyamatokra nem szabad publikus MI-eszközöket használni.

Ugyanígy könnyű egy képgeneráló appnak elküldözgetni a saját fényképeinket, hogy aztán vicces háttereket varázsoljon mögéjük, vagy épp tündefüleket és ördögszarvat pattintson a fejünkre – de ha átsiklunk a felhasználási feltételek apróbetűin, simán előfordulhat, hogy a fotóink illetéktelen kezekbe kerülhetnek. Igen, ez sem egy az egyben az MI “bűne”, mégis oda kell figyelni ezekre a helyzetekre.

Ha konkrétan az algoritmusok veszélyeit nézzük, az adódhat többek között abból, hogy minden ilyen MI-eszköz abból “főz”, amit láthatóvá tesznek számára a fejlesztők. Az még csak vicces vagy kínos helyzeteket teremthet, ha a ChatGPT-vel iratunk meg egy szakdolgozatot úgy, hogy az információforrásai között nem szerepelnek a legújabb vagy legpontosabb adatbázisok a témában, de ha valamilyen kiemelt fontosságú üzleti döntésben hagyatkozunk rá száz százalékban, akkor már komolyabb következményei is lehetnek annak, hogy kiadjuk a kezünkből az irányítást. Pontosan ezért egyelőre legfeljebb döntéstámogató, elemző segédekként, és nem konkrét irányítóként használják az üzleti életben a mesterséges intelligenciát: a segítségével gyorsabban lehet adatokat elemezni, folyamatokat megvilágítani és ezek alapján lehetőségeket felajánlani, de a döntés marad az embereknél.

Szabályozni, szabályozni, szabályozni!

A világ minden táján látják, hogy a mesterséges intelligencián alapuló megoldások jelenleg folyamatos fejlesztés alatt állnak, mind a működés, mind a felhasználási környezetek és módszerek tekintetében, épp ezért egyre-másra születnek azok a törvények és szabályozások, amelyek kereteket szabnak, fogalmakat tisztáznak és bizonyos esetekben tiltanak. Az Európai Parlament például júniusban szavazott az AI Actről, amely egy világszinten irányadónak számító jogszabály-javaslat, melynek végleges törvényi lefektetése jövőre várható. A célja az, hogy az MI Európán belüli fejlesztése és felhasználása mindenben megfeleljen az európai alapjogoknak és értékeknek, tehát többek között maradjon folyamatos emberi felügyelet alatt, emellett legyen teljesen átlátható és biztonságos, és mindig szolgálja a társadalom, valamint a környezet jólétét.

Ez persze nem ennyire egyszerű, a szabályokat nagyon mélyen részletezik. Többek között aszerint állapítanak meg kötelezettségeket szolgáltatók és felhasználók számára egyaránt, milyen kockázatot jelent az adott esetben az MI alkalmazása. Így például akár tiltanak is egyes alkalmazási területeket, mint például azt, hogy az MI társadalmi szint alapján rangsoroljon embereket, tehát a személyes jellemzői, neme, származása, anyagi helyzete vagy viselkedése alapján kategorizáljon be valakit.

Szintén tilos lesz a mesterséges intelligencia minden olyan alkalmazása, amely sérti a magánéletet, illetve bármilyen formában diszkriminatív – ide tartozik például a köztereken alkalmazott valós idejű és utólagos biometrikus azonosítás, a személyes adatok alapján végzett automatikus profilalkotás vagy a prediktív rendvédelem (utóbbi lényegében a “lehetséges bűnelkövetés” meghatározása, mint amilyet a Tom Cruise-féle Különvélemény című film is megjelenít). Nagy kockázatúnak minősíti az AI Act az olyan MI-megoldásokat, amelyek veszélyeztethetik az emberi egészséget vagy biztonságot. Tehát nem szabad például olyan szolgáltatást működtetni, ahol a mesterséges intelligencia a felhasználó által adott információk, tünetek alapján egyértelműen kijelentheti, milyen betegsége van az illetőnek, ehelyett inkább csak javaslatokat adhat, de nem hagyhatja ki a képletből a folyamat végén az emberi orvost.

Szintén meghatározza az AI Act azt is, hogy az MI-eszközökkel létrehozott tartalmaknál kötelező lesz feltüntetni, hogy algorutmusok készítették őket (így tehát senki nem irathat a saját neve alatt könyvet a ChatGPT-vel, vagy készíthet digitális műalkotást a DALL-E 2-vel). Végül pedig a szabályozás jogot ad a felhasználóknak arra, hogy panasszal élhessenek az MI-rendszerek alkalmazásával kapcsolatban.

A mesterséges intelligencia tehát önmagában nem mindenható, nem veszélyes és legfőképpen nem gonosz. Viszont a felhasználásával kapcsolatban valóban nagyon sok még a kérdőjel, és ezzel kapcsolatban csak részben segítenek a mostanában kialakuló szabályozások. A legfontosabb itt is, mint minden más területen, az emberi mérlegelés és a józan ész: az algoritmusokat okosan és óvatosan használva nem érhet minket baj. Az pedig teljesen más kérdés, hogy az MI mennyire alakítja át a világot például a munkaerőpiac szintjén – itt a szakértők szerint is fel kell készülni sok változásra, bár arról továbbra is megoszlanak a vélemények, hogy a különféle öntanuló megoldások, felokosított algoritmusok konkrétan „elveszik-e a munkánkat”, vagy inkább csak megkönnyítik egyes munkakörök elvégzését, hogy a monoton elemzések, adatgyűjtések és egyéb rutinfeladatok helyett kreatívabb, emberibb munkafázisokra koncentrálhassunk. A mesterséges intelligencia tehát biztosan tartogat kihívásokat – de a Skynettől egyelőre nagyon messze jár.